Интеграция с ClickHouse Cloud

Введение

ClickPipes - это управляемая платформа интеграции, которая упрощает прием данных из разнообразных источников до простого нажатия нескольких кнопок. Разработанная для самых требовательных рабочих нагрузок, надежная и масштабируемая архитектура ClickPipes гарантирует стабильную производительность и надежность. ClickPipes может быть использован как для долгосрочных потоковых нужд, так и для одноразовых задач загрузки данных.

Поддерживаемые источники данных

| Название | Логотип | Тип | Статус | Описание |

|---|---|---|---|---|

| Apache Kafka | Потоковые | Стабильно | Настройте ClickPipes и начните получать потоковые данные из Apache Kafka в ClickHouse Cloud. | |

| Confluent Cloud | Потоковые | Стабильно | Откройте комбинированную мощь Confluent и ClickHouse Cloud через нашу прямую интеграцию. | |

| Redpanda | Потоковые | Стабильно | Настройте ClickPipes и начните получать потоковые данные из Redpanda в ClickHouse Cloud. | |

| AWS MSK | Потоковые | Стабильно | Настройте ClickPipes и начните получать потоковые данные из AWS MSK в ClickHouse Cloud. | |

| Azure Event Hubs | Потоковые | Стабильно | Настройте ClickPipes и начните получать потоковые данные из Azure Event Hubs в ClickHouse Cloud. Подробности см. в FAQ по Azure Event Hubs. | |

| WarpStream | Потоковые | Стабильно | Настройте ClickPipes и начните получать потоковые данные из WarpStream в ClickHouse Cloud. | |

| Amazon S3 | Объектное хранилище | Стабильно | Настройте ClickPipes для приема больших объемов данных из объектного хранилища. | |

| Google Cloud Storage | Объектное хранилище | Стабильно | Настройте ClickPipes для приема больших объемов данных из объектного хранилища. | |

| DigitalOcean Spaces | Объектное хранилище | Стабильно | Настройте ClickPipes для приема больших объемов данных из объектного хранилища. | |

| Azure Blob Storage | Объектное хранилище | Стабильно | Настройте ClickPipes для приема больших объемов данных из объектного хранилища. | |

| Amazon Kinesis | Потоковые | Стабильно | Настройте ClickPipes и начните получать потоковые данные из Amazon Kinesis в ClickHouse Cloud. | |

| Postgres | DBMS | Стабильно | Настройте ClickPipes и начните получать данные из Postgres в ClickHouse Cloud. | |

| MySQL | DBMS | Публичная бета | Настройте ClickPipes и начните получать данные из MySQL в ClickHouse Cloud. | |

| MongoDB | DBMS | Приватный просмотр | Настройте ClickPipes и начните получать данные из MongoDB в ClickHouse Cloud. |

Более новые коннекторы будут добавлены в ClickPipes, вы можете узнать больше, связавшись с нами.

Список статических IP-адресов

Ниже приведены статические NAT IP-адреса (разделенные по регионам), которые ClickPipes использует для подключения к вашим внешним сервисам. Добавьте IP-адреса вашего экземпляра региона в белый список IP, чтобы разрешить трафик.

Для всех сервисов трафик ClickPipes будет исходить из региона по умолчанию на основе местоположения вашего сервиса:

- eu-central-1: Для всех сервисов в регионах ЕС. (это включает регионы GCP и Azure в ЕС)

- us-east-1: Для всех сервисов в AWS

us-east-1. - ap-south-1: Для услуг в AWS

ap-south-1, созданных 25 июня 2025 года или позже (услуги, созданные до этой даты, используют IP-адресаus-east-2). - ap-southeast-2: Для услуг в AWS

ap-southeast-2, созданных 25 июня 2025 года или позже (услуги, созданные до этой даты, используют IP-адресаus-east-2). - us-west-2: Для услуг в AWS

us-west-2, созданных 24 июня 2025 года или позже (услуги, созданные до этой даты, используют IP-адресаus-east-2). - us-east-2: Для всех остальных регионов, не указанных явно. (это включает регионы GCP и Azure в США)

| Регион AWS | IP-адреса |

|---|---|

| eu-central-1 | 18.195.233.217, 3.127.86.90, 35.157.23.2, 18.197.167.47, 3.122.25.29, 52.28.148.40 |

| us-east-1 | 54.82.38.199, 3.90.133.29, 52.5.177.8, 3.227.227.145, 3.216.6.184, 54.84.202.92, 3.131.130.196, 3.23.172.68, 3.20.208.150 |

| us-east-2 | 3.131.130.196, 3.23.172.68, 3.20.208.150, 3.132.20.192, 18.119.76.110, 3.134.185.180 |

| ap-south-1 (с 25 июня 2025 года) | 13.203.140.189, 13.232.213.12, 13.235.145.208, 35.154.167.40, 65.0.39.245, 65.1.225.89 |

| ap-southeast-2 (с 25 июня 2025 года) | 3.106.48.103, 52.62.168.142, 13.55.113.162, 3.24.61.148, 54.206.77.184, 54.79.253.17 |

| us-west-2 (с 24 июня 2025 года) | 52.42.100.5, 44.242.47.162, 52.40.44.52, 44.227.206.163, 44.246.241.23, 35.83.230.19 |

Настройка параметров ClickHouse

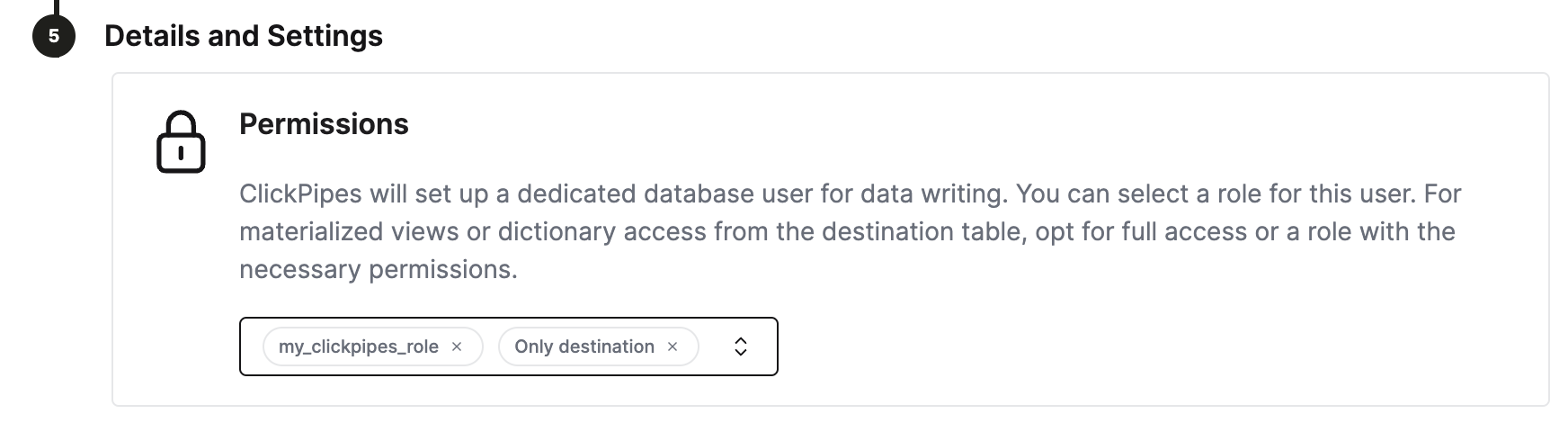

ClickHouse Cloud предоставляет разумные значения по умолчанию для большинства случаев использования. Однако, если вам нужно настроить некоторые параметры ClickHouse для таблиц назначения ClickPipes, специализированная роль для ClickPipes является самым гибким решением. Шаги:

- создайте пользовательскую роль

CREATE ROLE my_clickpipes_role SETTINGS .... См. синтаксис CREATE ROLE для подробностей. - добавьте пользовательскую роль к пользователю ClickPipes на шаге

Details and Settingsво время создания ClickPipes.

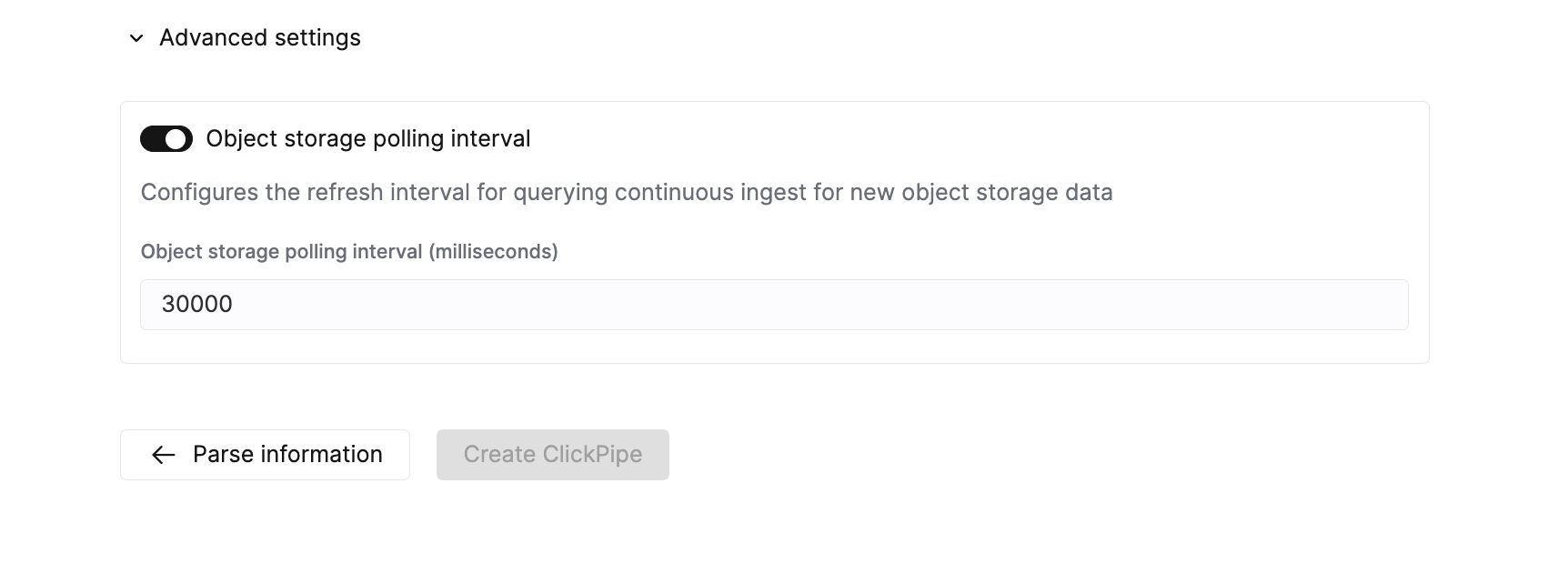

Настройка дополнительных параметров ClickPipes

ClickPipes предоставляет разумные значения по умолчанию, охватывающие требования большинства случаев использования. Если ваш случай использования требует дополнительной настройки, вы можете изменить следующие параметры:

Объектное хранилище ClickPipes

| Параметр | Значение по умолчанию | Описание |

|---|---|---|

Max insert bytes | 10GB | Количество байтов, обрабатываемых в одной批 вставки. |

Max file count | 100 | Максимальное количество файлов, обрабатываемых в одной批 вставки. |

Max threads | auto(3) | Максимальное количество параллельных потоков для обработки файлов. |

Max insert threads | 1 | Максимальное количество параллельных потоков вставки для обработки файлов. |

Min insert block size bytes | 1GB | Минимальный размер блока в байтах, который может быть вставлен в таблицу. |

Max download threads | 4 | Максимальное количество параллельных потоков загрузки. |

Object storage polling interval | 30s | Настраивает максимальный период ожидания перед вставкой данных в кластер ClickHouse. |

Parallel distributed insert select | 2 | Параметр параллельной распределенной вставки. |

Parallel view processing | false | Включать ли обработку присоединенных представлений параллельно вместо последовательно. |

Use cluster function | true | Обрабатывать ли файлы параллельно по нескольким узлам. |

Потоковые ClickPipes

| Параметр | Значение по умолчанию | Описание |

|---|---|---|

Streaming max insert wait time | 5s | Настраивает максимальный период ожидания перед вставкой данных в кластер ClickHouse. |

Сообщение об ошибках

ClickPipes будет хранить ошибки в двух отдельных таблицах в зависимости от типа ошибки, возникшей в процессе получения данных.

Ошибки записей

ClickPipes создаст таблицу рядом с вашей таблицей назначения с постфиксом <destination_table_name>_clickpipes_error. Эта таблица будет содержать любые ошибки из неправильно отформатированных данных или несовпадающей схемы и будет включать всю неверную информацию. Эта таблица имеет TTL в 7 дней.

Системные ошибки

Ошибки, связанные с работой ClickPipe, будут храниться в таблице system.clickpipes_log. Эта таблица будет хранить все остальные ошибки, связанные с работой вашего ClickPipe (сети, подключение и т. д.). Эта таблица имеет TTL в 7 дней.

Если ClickPipes не сможет подключиться к источнику данных после 15 минут или к месту назначения после 1 часа, экземпляр ClickPipes останавливается и сохраняет соответствующее сообщение в таблице системной ошибки (при условии, что экземпляр ClickHouse доступен).

FAQ

-

Что такое ClickPipes?

ClickPipes - это функция ClickHouse Cloud, которая упрощает пользователям подключение их служб ClickHouse к внешним источникам данных, в частности к Kafka. С помощью ClickPipes для Kafka пользователи могут легко непрерывно загружать данные в ClickHouse, делая их доступными для аналитики в реальном времени.

-

Поддерживает ли ClickPipes преобразование данных?

Да, ClickPipes поддерживает основное преобразование данных, предоставляя создание DDL. Вы можете затем применять более сложные преобразования к данным по мере их загрузки в целевую таблицу в службе ClickHouse Cloud, используя функцию материализованных представлений.

-

Влечет ли использование ClickPipes дополнительные расходы?

ClickPipes оплачивается по двум направлениям: загружаемым данным и вычислениям. Полные детали ценообразования доступны на этой странице. Запуск ClickPipes также может генерировать косвенные расходы на вычисление и хранение в службе назначения ClickHouse Cloud, аналогично любому рабочему процессу загрузки.

-

Есть ли способ обработать ошибки или сбои при использовании ClickPipes для Kafka?

Да, ClickPipes для Kafka автоматически повторит попытку в случае сбоя при получении данных из Kafka из-за любой операционной проблемы, включая сетевые проблемы, проблемы с подключением и т. д. В случае неправильно отформатированных данных или недействительной схемы ClickPipes сохранит запись в таблице record_error и продолжит обработку.